ADS-B Daten dekodieren, anzeigen und teilen

Nun beschreibe ich wie man die Daten dekodieren, anzeigen und mit Flightradar 24, Plane Finder, FlightAware, OpenSky Network und ADS-B Exchange teilen kann.

Da ich auch den watchdog des Raspberry nutze, kann es sein, das dieser ab und zu neu gestartet wird. Aus diesem Grund nutze ich für alle ABS-B Sachen ein Autostart Skript. Die Feeder bringen schon ein Skript dafür mit. Für modesmixer2 und Virtual Radar Server habe ich ein eigenes geschrieben und hier hinterlegt.

dump1090-mutability

installieren (mutability-repo_0.1.4_armhf.deb durch die aktuelle Versionsnummer ersetzen. Die aktuelle Versionsnummer kann man hier finden.)

cd /home/pi/Downloads

wget https://github.com/mutability/mutability-repo/releases/download/v0.1.0/mutability-repo_0.1.4_armhf.deb

sudo dpkg -i mutability-repo_*_armhf.deb

sudo apt-get update && sudo apt-get install dump1090-mutability

und konfigurieren.

sudo dpkg-reconfigure dump1090-mutability

Nach einen Neustart des Service dump1090-mutability sollte die Software betriebsbereit sein.

sudo service dump1090-mutability restart

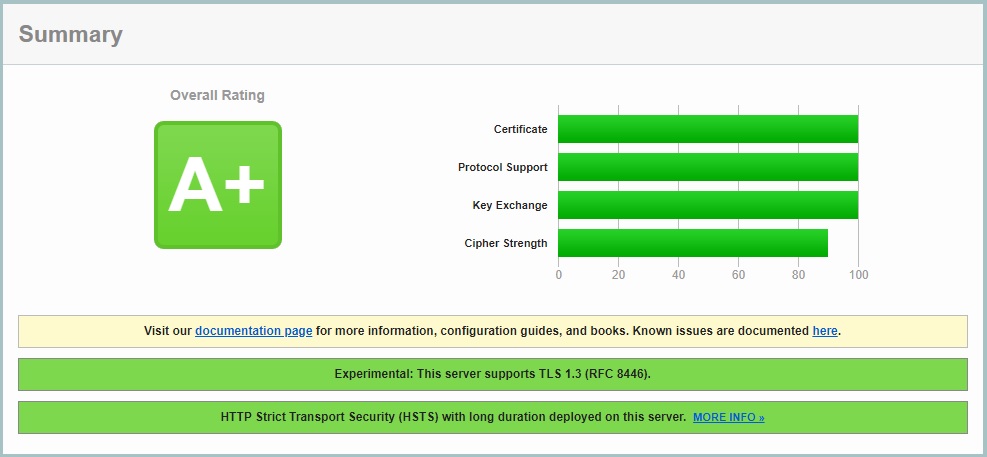

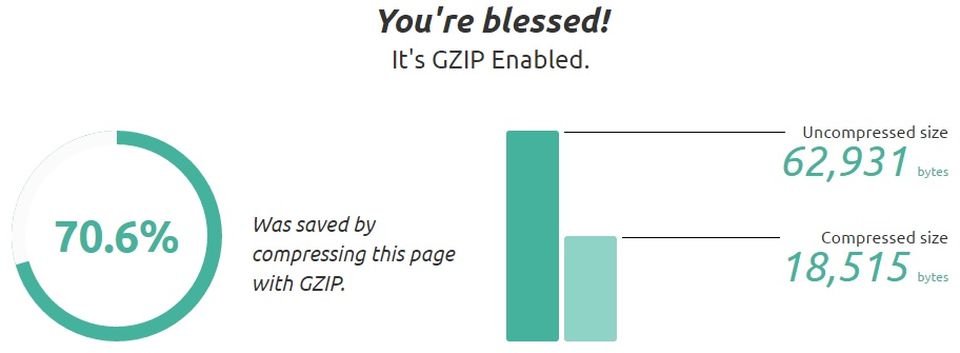

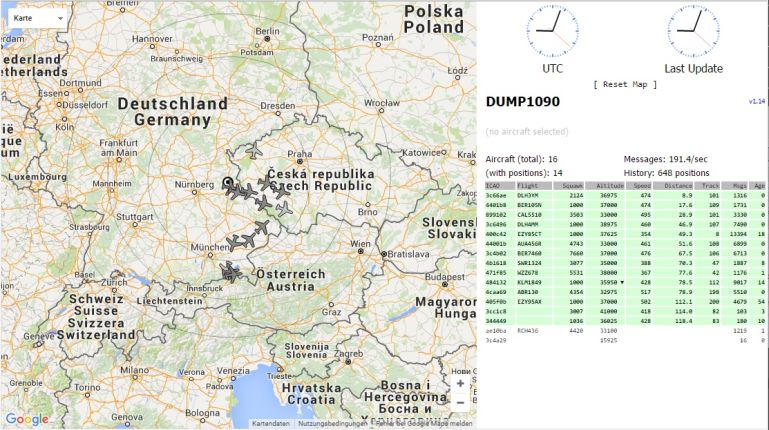

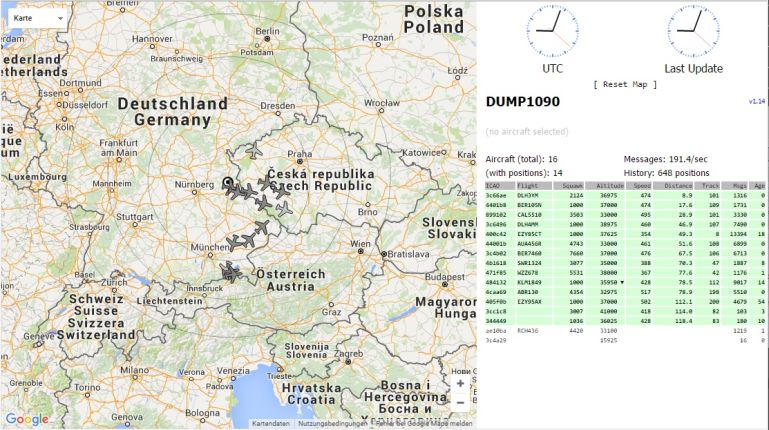

Das Webinterface ist nun über 127.0.0.1:<Port> erreichbar und sollte so ähnlich aussehen.

Das Webinterface von dump1090-mutability kann man im Internet über einen nginx reverse proxy bereitstellen. Dafür die Konfiguration von nginx öffnen,

sudo nano /etc/nginx/sites-available/default

folgende Zeilen hinzufügen

###### beginn dump1090 #########

#

rewrite ^/dump1090/$ /dump1090/gmap.html permanent;

rewrite ^/dump1090$ /dump1090/gmap.html permanent;

#

location /dump1090 {

rewrite /dump1090/(.*) /$1 break;

proxy_pass http://127.0.0.1:<Port>;

proxy_redirect off;

proxy_set_header Host $host;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

}

#

### replace dump1090 internal web server

#location /dump1090/ {

# alias /usr/share/dump1090-mutability/html/;

#}

#location /dump1090/data/ {

# alias /run/dump1090-mutability/;

#}

#location /dump1090/db/ {

# alias /var/cache/dump1090-mutability/db/;

#}

### replace dump1090 internal web server

#

###### ende dump1090 #########

und speichern. Nach einen neustart des Service nginx

sudo service nginx restart

ist das Webinterface über die Adresse <domain>/dump1090 im Internet erreichbar.

Hinweise:

Die Konfiguration von dump1090-mutability wird in der Datei /etc/default/dump1090-mutability gespeichert. Die Einträge daraus werden in der Datei /etc/init.d/dump1090-mutability ausgelesen und umgewandelt in die Parameter, welche an dump1090-mutability übergeben werden können. Ein Übersicht über die möglichen Parameter kann man über die Hilfe erhalten.

dump1090-mutability --help

Im Header der Ausgabe findet man auch die aktuelle Versionsnummer.

dump1090-fa

https://de.flightaware.com/adsb/piaware/install

cd /home/pi/Downloads

wget http://de.flightaware.com/adsb/piaware/files/packages/pool/piaware/p/piaware-support/piaware-repository_3.7.2_all.deb

sudo dpkg -i piaware-repository_3.7.2_all.deb

sudo apt-get update

sudo apt-get install dump1090-fa

Virtual Radar Server

Installationsvoraussetung ist mono, da die Software in .net erstellt ist.

sudo apt-get install mono-complete

Installieren.

cd /home/pi/Downloads

wget http://www.virtualradarserver.co.uk/Files/VirtualRadar.tar.gz

Der automatische Start erfolgt bei mir durch ein selbst erstelltes Service Script. Dieses kann mit den Befehl

sudo nano /etc/init.d/vrs

erstellt werden. Den folgenden Ihnalt einfügen.

#! /bin/sh

### BEGIN INIT INFO

# Provides: VirtualRadarServer

# Required-Start: $remote_fs $syslog

# Required-Stop: $remote_fs $syslog

# Default-Start: 2 3 4 5

# Default-Stop: 0 1 6

# Short-Description: web page for ADSB

# Description: my own ADS-B data with Virtual Radar Server

### END INIT INFO

# PATH should only include /usr/* if it runs after the mountnfs.sh script

PATH=/sbin:/usr/sbin:/bin:/usr/bin

DESC="Virtual Radar Sever for ADSB"

NAME=VirtualRadar

DAEMON="/usr/bin/mono /SDR/VRS/$NAME.exe"

DAEMON_ARGS="-workingFolder:/mnt/usbhdd/SDR/Resources/VRS -nogui"

PIDFILE=/var/run/$NAME.pid

SCRIPTNAME=/etc/init.d/vrs

# Exit if the package is not installed

#[ -x "$DAEMON" ] || exit 0

# Load the VERBOSE setting and other rcS variables

. /lib/init/vars.sh

# Define LSB log_* functions.

# Depend on lsb-base (>= 3.2-14) to ensure that this file is present

# and status_of_proc is working.

. /lib/lsb/init-functions

#

# Function that starts the daemon/service

#

do_start()

{

# Return

# 0 if daemon has been started

# 1 if daemon was already running

# 2 if daemon could not be started

start-stop-daemon --start --background --pidfile $PIDFILE --exec $DAEMON --test > /dev/null \

|| return 1

start-stop-daemon --start --background --pidfile $PIDFILE --make-pidfile --exec $DAEMON -- $DAEMON_ARGS \

|| return 2

# Add code here, if necessary, that waits for the process to be ready

# to handle requests from services started subsequently which depend

# on this one. As a last resort, sleep for some time.

}

#

# Function that stops the daemon/service

#

do_stop()

{

# Return

# 0 if daemon has been stopped

# 1 if daemon was already stopped

# 2 if daemon could not be stopped

# other if a failure occurred

start-stop-daemon --stop --quiet --retry=TERM/30/KILL/5 --pidfile $PIDFILE --exec $DAEMON

RETVAL="$?"

[ "$RETVAL" = 2 ] && return 2

# Wait for children to finish too if this is a daemon that forks

# and if the daemon is only ever run from this initscript.

# If the above conditions are not satisfied then add some other code

# that waits for the process to drop all resources that could be

# needed by services started subsequently. A last resort is to

# sleep for some time.

start-stop-daemon --stop --quiet --oknodo --retry=0/30/KILL/5 --exec $DAEMON

[ "$?" = 2 ] && return 2

# Many daemons don't delete their pidfiles when they exit.

rm -f $PIDFILE

return "$RETVAL"

}

#

# main

#

case "$1" in

start)

[ "$VERBOSE" != no ] && log_daemon_msg "Starting $DESC" "$NAME"

do_start

case "$?" in

0|1) [ "$VERBOSE" != no ] && log_end_msg 0 ;;

2) [ "$VERBOSE" != no ] && log_end_msg 1 ;;

esac

;;

stop)

[ "$VERBOSE" != no ] && log_daemon_msg "Stopping $DESC" "$NAME"

do_stop

case "$?" in

0|1) [ "$VERBOSE" != no ] && log_end_msg 0 ;;

2) [ "$VERBOSE" != no ] && log_end_msg 1 ;;

esac

;;

#status)

#status_of_proc "$DAEMON" "$NAME" && exit 0 || exit $?

#;;

#reload|force-reload)

#

# If do_reload() is not implemented then leave this commented out

# and leave 'force-reload' as an alias for 'restart'.

#

#log_daemon_msg "Reloading $DESC" "$NAME"

#do_reload

#log_end_msg $?

#;;

restart|force-reload)

#

# If the "reload" option is implemented then remove the

# 'force-reload' alias

#

log_daemon_msg "Restarting $DESC" "$NAME"

do_stop

case "$?" in

0|1)

do_start

case "$?" in

0) log_end_msg 0 ;;

1) log_end_msg 1 ;; # Old process is still running

*) log_end_msg 1 ;; # Failed to start

esac

;;

*)

# Failed to stop

log_end_msg 1

;;

esac

;;

*)

#echo "Usage: $SCRIPTNAME {start|stop|restart|reload|force-reload}" >&2

echo "Usage: $SCRIPTNAME {start|stop|status|restart|force-reload}" >&2

exit 3

;;

esac

:

Die Konfiguaration ist etwas umfangreicher. Doch auch diese will ich hier noch beschreiben

.

.

.

.

.

.

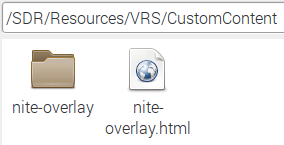

Nite-overlay mit dem Custom Content Plugin

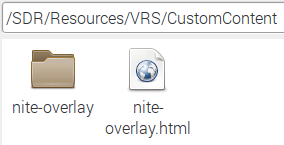

In den Ordner /SDR/Resources/VRS/CustomContent wechseln.

cd /SDR/Resources/VRS/CustomContent

Eine neue html- Datei erstellen mit

sudo nano nite-overlay.html

und den folgenden Inhalt einfügen.

<script type="text/javascript">

if(VRS && VRS.globalDispatch && VRS.serverConfig) {

VRS.globalDispatch.hook(VRS.globalEvent.bootstrapCreated, function(bootStrap) {

bootStrap.hookInitialised(function(pageSettings) {

// Load the nite-overlay.js script from https://github.com/rossengeorgiev/nite-overlay

// it gets loaded so we need to load it dynamically after Google Maps has been loaded.

// We can't just have a <script > tag for it.

if(pageSettings.mapPlugin && pageSettings.mapPlugin.getNativeType() === 'GoogleMaps') {

VRS.scriptManager.loadScript({

key: 'nite-overlay',

url: 'nite-overlay/nite-overlay.js',

success: function() {

var map = pageSettings.mapPlugin.getNative();

nite.init(map);

setInterval(function() { nite.refresh() }, 10000); // refresh every 10s

}

});

}

});

});

}

</script>

Nun das script von GitHub klonen.

git clone https://github.com/rossengeorgiev/nite-overlay

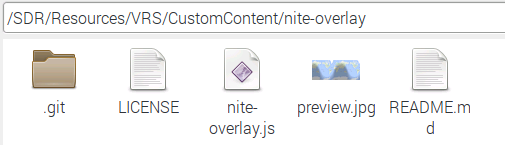

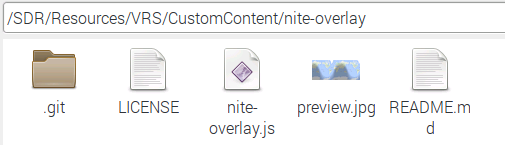

Der Ordnerinhalt sollte nun wie folgt aussehen.

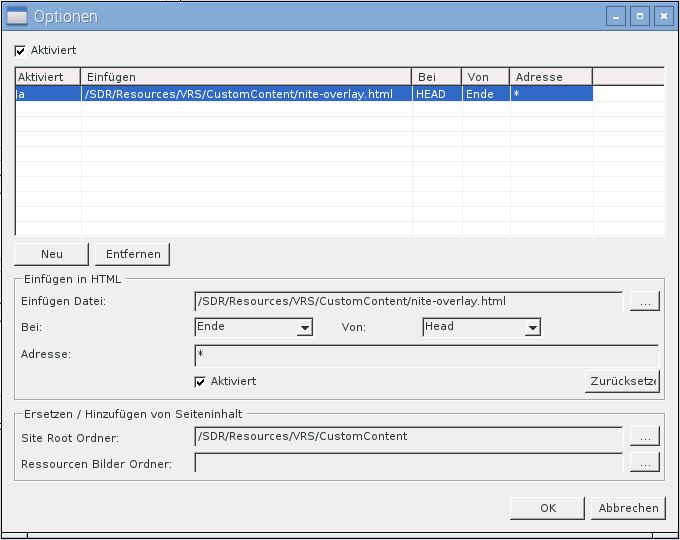

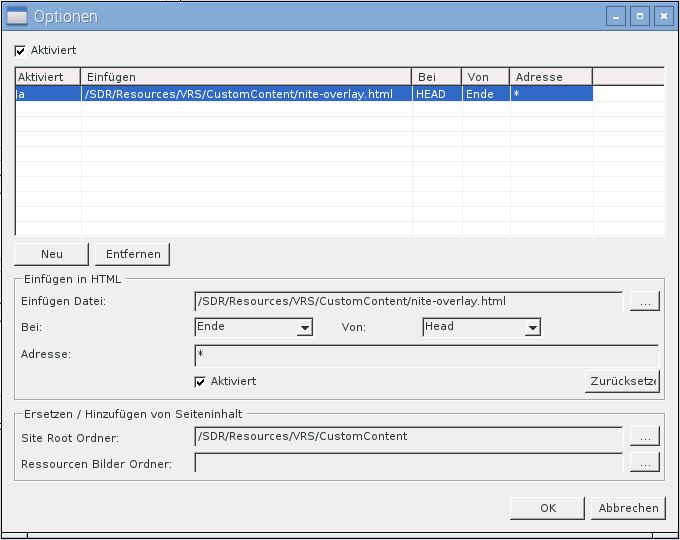

Im Custom Content Plugin muss folgender Eintrag hinzugefügt werden.

Nginx reverse Proxy

Das Webinterface von Virtual Radar Server kann man im Internet über einen nginx reverse proxy bereitstellen. Dafür die Konfiguration von nginx öffnen,

sudo nano /etc/nginx/sites-available/default

folgende Zeilen hinzufügen

###### beginn Virtual Radar Server #########

#

if ($mobile_request = true) {

rewrite ^/vr/$ /VirtualRadar\mobile.html permanent;

rewrite ^/vr$ /VirtualRadar\mobile.html permanent;

}

if ($mobile_request = false) {

rewrite ^/vr/$ /VirtualRadar\desktop.html permanent;

rewrite ^/vr$ /VirtualRadar\desktop.html permanent;

}

#

location /vrs {

rewrite /vrs/(.*) /$1 break;

proxy_pass 127.0.0.1:8082;

proxy_redirect off;

proxy_set_header Host $host;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

}

#

###### ende Virtual Radar Server #########

und speichern. Nach einen neustart des Service nginx

sudo service nginx restart

ist das Webinterface über die Adresse <domain>/vr im Internet erreichbar.

modesmixer2

Das Programm muss manuell über die Downloadseite Anbieter geladen werden. Nach den herunterladen die *.tgz entpacken. Die so gewonnene Datei modesmixer2 nach /usr/bin kopieren.

Die Konfiguration und der automatische Start erfolgen bei mir durch ein selbst erstelltes Service Script. Dieses mit

sudo nano /etc/init.d/modesmixer2

erstellen und den folgenden Ihnalt einfügen. Dabei die Einträge DAEMON_ARGS= mit eigenen Werten anpassen

#! /bin/sh

### BEGIN INIT INFO

# Provides: modesmixer2

# Required-Start: $remote_fs $syslog

# Required-Stop: $remote_fs $syslog

# Default-Start: 2 3 4 5

# Default-Stop: 0 1 6

# Short-Description: web page for ADSB

# Description: my own ADS-B data with modesmixer2

# inServer port 30006

### END INIT INFO

# PATH should only include /usr/* if it runs after the mountnfs.sh script

PATH=/sbin:/usr/sbin:/bin:/usr/bin

DESC="mixer for ADSB"

NAME=modesmixer2

DAEMON=/usr/bin/$NAME

DAEMON_ARGS="--inConnect 127.0.0.1:30003 --inConnect 127.0.0.1:30005 --inServer 30006 --location <Receiver Latitude:Longitude> --metric --web <Port> --log-noconsole --outServer beast:30007"

PIDFILE=/var/run/$NAME.pid

SCRIPTNAME=/etc/init.d/$NAME

# Exit if the package is not installed

[ -x "$DAEMON" ] || exit 0

# Load the VERBOSE setting and other rcS variables

. /lib/init/vars.sh

# Define LSB log_* functions.

# Depend on lsb-base (>= 3.2-14) to ensure that this file is present

# and status_of_proc is working.

. /lib/lsb/init-functions

#

# Function that starts the daemon/service

#

do_start()

{

# Return

# 0 if daemon has been started

# 1 if daemon was already running

# 2 if daemon could not be started

start-stop-daemon --start --background --pidfile $PIDFILE --exec $DAEMON --test > /dev/null \

|| return 1

start-stop-daemon --start --background --pidfile $PIDFILE --make-pidfile --exec $DAEMON -- $DAEMON_ARGS \

|| return 2

# Add code here, if necessary, that waits for the process to be ready

# to handle requests from services started subsequently which depend

# on this one. As a last resort, sleep for some time.

}

#

# Function that stops the daemon/service

#

do_stop()

{

# Return

# 0 if daemon has been stopped

# 1 if daemon was already stopped

# 2 if daemon could not be stopped

# other if a failure occurred

start-stop-daemon --stop --quiet --retry=TERM/30/KILL/5 --pidfile $PIDFILE --name $NAME

RETVAL="$?"

[ "$RETVAL" = 2 ] && return 2

# Wait for children to finish too if this is a daemon that forks

# and if the daemon is only ever run from this initscript.

# If the above conditions are not satisfied then add some other code

# that waits for the process to drop all resources that could be

# needed by services started subsequently. A last resort is to

# sleep for some time.

start-stop-daemon --stop --quiet --oknodo --retry=0/30/KILL/5 --exec $DAEMON

[ "$?" = 2 ] && return 2

# Many daemons don't delete their pidfiles when they exit.

rm -f $PIDFILE

return "$RETVAL"

}

#

# main

#

case "$1" in

start)

[ "$VERBOSE" != no ] && log_daemon_msg "Starting $DESC" "$NAME"

do_start

case "$?" in

0|1) [ "$VERBOSE" != no ] && log_end_msg 0 ;;

2) [ "$VERBOSE" != no ] && log_end_msg 1 ;;

esac

;;

stop)

[ "$VERBOSE" != no ] && log_daemon_msg "Stopping $DESC" "$NAME"

do_stop

case "$?" in

0|1) [ "$VERBOSE" != no ] && log_end_msg 0 ;;

2) [ "$VERBOSE" != no ] && log_end_msg 1 ;;

esac

;;

#status)

#status_of_proc "$DAEMON" "$NAME" && exit 0 || exit $?

#;;

#reload|force-reload)

#

# If do_reload() is not implemented then leave this commented out

# and leave 'force-reload' as an alias for 'restart'.

#

#log_daemon_msg "Reloading $DESC" "$NAME"

#do_reload

#log_end_msg $?

#;;

restart|force-reload)

#

# If the "reload" option is implemented then remove the

# 'force-reload' alias

#

log_daemon_msg "Restarting $DESC" "$NAME"

do_stop

case "$?" in

0|1)

do_start

case "$?" in

0) log_end_msg 0 ;;

1) log_end_msg 1 ;; # Old process is still running

*) log_end_msg 1 ;; # Failed to start

esac

;;

*)

# Failed to stop

log_end_msg 1

;;

esac

;;

*)

#echo "Usage: $SCRIPTNAME {start|stop|restart|reload|force-reload}" >&2

echo "Usage: $SCRIPTNAME {start|stop|status|restart|force-reload}" >&2

exit 3

;;

esac

:

Die möglichen Parameter für DAEMON_ARGS= kann man über die Hilfe erhalten.

modesmixer2 --help

Den Service modesmixer2 nun starten mit

sudo service modesmixer2 restart

Jetzt kann man das Webinterface über 127.0.0.1:<Port> erreichen.

Daten mit Flightradar 24 teilen

Feeder installieren

sudo bash -c "$(wget -O - http://repo.feed.flightradar24.com/install_fr24_rpi.sh)"

sudo apt-get install fr24feed

und konfigurieren.

fr24feed --signup

Step 1.1 - Enter your email address (username@domain.tld)

$:<Email Adresse> eintragen

Step 1.2 - If you used to feed FR24 with ADS-B data before enter your sharing key.

If you don't remember your sharing key, pelase use the retrival form:

http://feed.flightradar24.com/forgotten_key.php

$:<Flightradar 24 sharing key> eintragen oder leer lassen, wenn man keinen hat

Step 1.3 - Would you like to participate in MLAT calculations? (yes/no)

$:no

Would you like to use autoconfig (*yes*/no)

$:no

Step 4.1 - Receiver selection:

1 - DVBT Stick (USB)

-----------------------------------------------------

2 - SBS1, SBS1er or SBS3 (USB/Network)

3 - ModeS Beast (USB/Network)

4 - AVR Compatible (DVBT over network, etc)

5 - microADSB (USB/Network)

Enter your receiver type (1-5)

$:3

Step 4.2 - Please select connection type:

1 - Network connection

2 - USB directly to this computer

Enter your connection type (1-2)

$:1

Step 4.3A - Please enter your receiver's IP address/hostname

$:127.0.0.1

Step 4.3B - Please enter your receiver's data port number

$:30005

Step 5.1 - Would you like to enable RAW data feed on port 30334 (yes/no)

$:no

Step 5.2 - Would you like to enable Basestation data feed on port 30003 (yes/no)

$:no

Step 6A - Please select desired logfile mode:

0 - Disabled

1 - 48 hour, 24h rotation

2 - 72 hour, 24h rotation

Select logfile mode (0-2)

$:0

Step 6B - Please enter desired logfile path (/var/log):

$:Eingabetaste drücken

Den Service fr24feed neu starten, damit die Einstellungen aktiv werden.

sudo service fr24feed restart

Die ADS-B Daten sollten jetzt mit Flightradar 24 geteilt werden. Der Feeder hat ein Webinterface, in welchen man sehen kann, ob alles funktioniert. Die Adresse lautet 127.0.0.1:8754

Hinweise:

Den Ordner /var/log halte ich im RAM. Das ist der Grund warum ich das Logging bei der Konfiguration deaktiviert habe. Das kann jederzeit über das Webinterface unter folgender Adresse geändert werden: 127.0.0.1:8754/settings.html.

Daten mit Plane Finder teilen

Feeder installieren (pfclient_3.0.2080_armhf.deb durch die aktuelle Versionsnummer ersetzen. Die aktuelle Versionsnummer kann man hier finden.)

cd /home/pi/Downloads

wget http://client.planefinder.net/pfclient_3.0.2080_armhf.deb

sudo dpkg -i pfclient_*_armhf.deb

Feeder konfigurieren.

- Das Webinerface 127.0.0.1:30053 öffnen.

- <Email Adresse>, <Receiver Latitude> and <Receiver Longitude> eintragen.

- Wenn man keinen Sharecode hat, muss man "Create a new sharecode" wählen. Danach erhält man diesen an die eben angegebene Email Adresse.

- Wenn man einen Sharecode hat, kann man mit "I already have a sharecode!" weitermachen, <Plane Finder Sharecode>, <Receiver Latitude> und <Receiver Longitude> eintragen und "Assign sharecode" drücken.

- Es öffnet sich die Seite "Receiver data format". Hier "Beast" auswählen, die IP Adresse 127.0.0.1, den Port 30005 eintragen und mit "Complete configuration" abschliessen.

Nun die Seite 127.0.0.1:30053/map.html des Webinterface öffnen. Wenn alles gut gelaufen ist, kann man Flugzeuge sehen und die ADS-B Daten sollten jetzt mit Plane Finder geteilt werden.

Hinweise:

Da ich /var/log im RAM halte, gibt es nach den Neustart des Raspberry ein Problem. Der Planefinder Client versucht im Ordner /var/log/pfclient seine Log- Dateien anzulegen. Wenn der Ordner nicht vorhanden ist, wird der Service pfclient nicht gestartet. Für mich scheint die folgende Lösung am besten.

sudo nano /etc/int.d/pfclient

Den Eintrag

LOGFILE=/var/log/pfclient

zu

LOGFILE=/dev/nul

ändern. Dadurch ist das Standard- Logging deaktiviert, aber auch im Webinterface 127.0.0.1:30053/logs.html nicht mehr zu sehen.

Den Eintrag

start-stop-daemon --start --exec $DAEMON -- -d -i $PIDFILE -z $CONFIGFILE -y $LOGFILE $ 2>/var/log/pfclient/error.log

habe ich so gelassen, um im Fehlerfall Informationen zu haben. Damit das aber funktioniert, muss man folgende Zeile nach der Variablen Deklaration hinzufügen.

mkdir -p /var/log/pfclient

So wird beim starten des Service pfclient den Ordner /var/log/pfclient angelegt.

Daten mit FlightAware teilen

Feeder installieren (piaware_2.1-2_armhf.deb durch die aktuelle Versionsnummer ersetzen. Die aktuelle Versionsnummer kann man hier finden.)

cd /home/pi/Downloads

wget http://flightaware.com/adsb/piaware/files/piaware_2.1-2_armhf.deb

sudo dpkg -i piaware_*_armhf.deb

sudo apt-get install -fy

und konfigurieren.

sudo piaware-config -autoUpdate 1 -manualUpdate 1

sudo piaware-config -user <FlightAware Benutzername> -password

> das <FlightAware Passwort> eingeben

Danach den Service piaware neu starten.

sudo service piaware restart

Die ADS-B Daten sollten jetzt mit FlightAware geteilt werden.

Die Konfiguaration von piaware wird alternativ in den folgenden Dateien abgelegt.

- /root/.piaware

- /boot/piaware-config.txt

- /etc/piaware.conf

Die Konfiguration kann mit folgenden Befehl abgefragt werden.

sudo piaware-config

MLAT von piaware selbst nutzen

Die MLAT Berechnungen soll piaware auf Port 30006 ausgeben.

sudo nano /etc/piaware.conf

mlatResultsFormat "beast,connect,127.0.0.1:30006"

sudo service piaware restart

Durch diese Einstellung verbindet sich piaware automatisch zu modesmixer2, da hier der inServer auf Port 30006 lauscht. Nach der Verbindung sind die durch MLAT berechneten Flieger sichtbar.

Zu diesen Thema kann man hier weitere nützliche Informationen finden.

Daten mit OpenSky Netzwerk teilen

Dokumentation

Installieren

cd /home/pi/Downloads

wget https://opensky-network.org/files/firmware/opensky-feeder_latest_armhf.deb

sudo dpkg -i opensky-feeder_latest_armhf.deb

Updates über apt erhalten

sudo apt-get install apt-transport-https ca-certificates

wget -O - https://opensky-network.org/files/firmware/opensky.gpg.pub | sudo apt-key add -

sudo bash -c "echo deb https://opensky-network.org/repos/debian opensky custom > /etc/apt/sources.list.d/opensky.list"

sudo apt-get update

sudo apt-get update

sudo apt-get upgrade

Daten mit ADS-B Exchange teilen

über ADS-B Exchange services

Die Dokumentation ist so gut, dass ich hier nichts mehr anfügen will.

cd /home/pi/src

git clone https://github.com/adsbxchange/adsb-exchange.git

cd adsb-exchange

chmod 755 setup.sh

sudo ./setup.sh

Jetzt sollten die Daten auch mit ADS-B Exchange geteilt werden.

über modesmixer2

Folgender Eintrag wird zu den Parametrn von modesmixer2 hinzugefügt.

-outConnect beast:feed.adsbexchange.com:30005

Alles prüfen (Endkontrolle)

#!/bin/bash

clear

service dump1090-mutability status

echo -e

ps ax | grep dump1090-mutability

echo -e

service vrs status

echo -e

ps ax | grep vrs

echo -e

service fr24feed status

echo -e

ps ax | grep fr24feed

echo -e

service pfclient status

echo -e

ps ax | grep pfclient

echo -e

service piaware status

echo -e

ps ax | grep piaware

echo -e

service opensky_feeder status

echo -e

ps ax | grep opensky_feeder

echo -e

service adsbexchange-feed status

echo -e

ps ax | grep adsbexchange-feed

echo -e

service adsbexchange-mlat status

echo -e

ps ax | grep adsbexchange-mlat

echo -e

Den RPi-Monitor erweitern

Damit ich stets über den Zustand der Services im Bilde bin, habe ich mein RPi- Monitor Webinterface um diese Informationen erweitert.

Hierzu eine neue Datei erstellen mit

sudo nano /etc/rpimonitor/template/avionics.conf

und den folgenden Inhalt hinein kopieren. Die Adressen müssen individuell angepasst werden.

#######################################################################

# ADSB information

# Page: 1

# Information Status Statistics

# - count total - yes - yes

# - dump1090 - yes - no

# - vrs - yes - no

# - fr24feed - yes - no

# - pfclient - yes - no

# - piaware - yes - no

# - opensky_feeder - yes - no

# - adsbexchange -feed -mlat - yes - no

########################################################################

dynamic.21.name=du1,du2

dynamic.21.source=service dump1090-mutability status

dynamic.21.regexp=((?:active|inactive|failed|activating|deactivating).*)(\(.*)

static.21.name=duv

static.21.source=dump1090-mutability --help

static.21.regexp=dump1090-mutability v(.*)

dynamic.22.name=vr1,vr2

dynamic.22.source=service vrs status

dynamic.22.regexp=((?:active|inactive|failed|activating|deactivating).*)(\(.*)

dynamic.23.name=fr1,fr2

dynamic.23.source=service fr24feed status

dynamic.23.regexp=((?:active|inactive|failed|activating|deactivating).*)(\(.*)

static.23.name=frv

static.23.source=fr24feed --version

static.23.regexp=^(\d+(.\d){0,2}(.*)?)$

dynamic.24.name=pf1,pf2

dynamic.24.source=service pfclient status

dynamic.24.regexp=((?:active|inactive|failed|activating|deactivating).*)(\(.*)

static.24.name=pfv

static.24.source=pfclient -v

static.24.regexp=version:(.*)

dynamic.25.name=pi1,pi2

dynamic.25.source=service piaware status

dynamic.25.regexp=((?:active|inactive|failed|activating|deactivating).*)(\(.*)

static.25.name=piv

static.25.source=piaware -v

static.25.regexp=(^.*)

dynamic.26.name=vrshttp

dynamic.26.source=netstat -nlt

dynamic.26.regexp=tcp .*:(8082).*LISTEN

dynamic.27.name=fr24feedhttp

dynamic.27.source=netstat -nlt

dynamic.27.regexp=tcp .*:(8754).*LISTEN

dynamic.28.name=pfclienthttp

dynamic.28.source=netstat -nlt

dynamic.28.regexp=tcp .*:(30053).*LISTEN

dynamic.29.name=vrtac

dynamic.29.source=curl -sS http://127.0.0.1:8082/VirtualRadar/AircraftList.json?fMilQ=true | gunzip | jq '.totalAc'

dynamic.29.regexp=(^.*)

dynamic.29.postprocess=$1

dynamic.29.rrd=GAUGE

dynamic.30.name=osn1,osn2

dynamic.30.source=service opensky-feeder status

dynamic.30.regexp=((?:active|inactive|failed|activating|deactivating).*)(\(.*)

dynamic.31.name=adsbexf1,adsbexf2

dynamic.31.source=service adsbexchange-feed status

dynamic.31.regexp=((?:active|inactive|failed|activating|deactivating).*)(\(.*)

dynamic.32.name=adsbexm1,adsbexm2

dynamic.32.source=service adsbexchange-mlat status #systemctl status adsbechange-mlat

dynamic.32.regexp=((?:active|inactive|failed|activating|deactivating).*)(\(.*)

web.statistics.1.content.32.name=Aircraft count

web.statistics.1.content.32.graph.1=vrtac

web.statistics.1.content.32.ds_graph_options.vrtac.label=total

web.status.1.content.10.name=Avionics

web.status.1.content.10.icon=avionics.png

web.status.1.content.10.line.1="count total: " + data.vrtac

web.status.1.content.10.line.2="

"

web.status.1.content.10.line.3="dump1090 " + "" + data.duv + ""

web.status.1.content.10.line.4="service dump1090-mutability status: " + data.du1 + data.du2 + ""

web.status.1.content.10.line.5="

"

web.status.1.content.10.line.6="" + "Virtual Radar Server" + ""

web.status.1.content.10.line.7="service vrs status: " + data.vr1 + data.vr2 + ""

web.status.1.content.10.line.8=Label(data.vrshttp,"==8082","OK","label-success") + Label(data.vrshttp,"!=8082","KO","label-danger") + " web interface" + " local" + "|www"

web.status.1.content.10.line.9="

"

web.status.1.content.10.line.10="" + "Flight Radar 24" + "" + " " + "" + data.frv + ""

web.status.1.content.10.line.11="service fr24feed status: " + data.fr1 + data.fr2 + ""

web.status.1.content.10.line.12=Label(data.fr24feedhttp,"==8754","OK","label-success") + Label(data.fr24feedhttp,"!=8754","KO","label-danger") + " web interface" + " local"

web.status.1.content.10.line.13="

"

web.status.1.content.10.line.14="" + "Plane Finder" + "" + " " + "" + data.pfv + "" + " " + "(" + "" + "Status" + "" + ")"

web.status.1.content.10.line.15="service pfclient status: " + data.pf1 + data.pf2 + ""

web.status.1.content.10.line.16=Label(data.pfclienthttp,"==30053","OK","label-success") + Label(data.pfclienthttp,"!=30053","KO","label-danger") + " web interface" + " local" + "|www"

web.status.1.content.10.line.17="

"

web.status.1.content.10.line.18="" + "FlightAware" + "" + " " + "" + data.piv + ""

web.status.1.content.10.line.19="service piaware status: " + data.pi1 + data.pi2 + ""

web.status.1.content.10.line.20="

"

web.status.1.content.10.line.21="" + "OpenSky Network" + ""

web.status.1.content.10.line.22="service opensky-feeder status: " + data.osn1 + data.osn2 + ""

web.status.1.content.10.line.23="

"

web.status.1.content.10.line.24="" + "ADS-B Exchange" + "" + " " + "(" + "" + "Status" + "" + ")"

web.status.1.content.10.line.25="service adsbexchange-feed status: " + data.adsbexf1 + data.adsbexf2 + ""

web.status.1.content.10.line.26="service adsbexchange-mlat status: " + data.adsbexm1 + data.adsbexm2 + ""

Die neue Datei an beliebiger Stelle in der Datei /etc/rpimonitor/data.conf einbinden

sudo nano /etc/rpimonitor/data.conf

include=/etc/rpimonitor/template/avionics.conf

das icon (avionics.png) in den Ordner /usr/share/rpimonitor/web/img/ kopieren und den Service rpimonitor neu starten.

sudo service rpimonitor restart